Digitalisierung

Politische Meinungsbildung im Netz

Die Digitalisierung durchdringt unsere Gesellschaft und verändert sie nachhaltig.

© gettyimages / oatawaUnser Informations- und Mediensystem verändert sich radikal: Wir informieren uns online, wir diskutieren auf Sozialen Netzwerken und bilden unsere Meinung digital – die Sozialen Medien ergänzen immer mehr die traditionellen Medien wie Zeitung, Radio und Fernsehen. Die Deutungshoheit über Ereignisse und Aussagen liegt nicht mehr allein bei journalistischen Gatekeepern. Demokratische Prozesse und unsere Debattenkultur sehen sich deshalb großen Herausforderungen gegenüber, denn auch die politische Welt wird immer digitaler. Politikschaffende können Echtzeit-Statements auf Twitter abgeben, und Wählerinnen und Wähler sind besser zu erreichen als im klassischen Straßen- und Haustürwahlkampf.

Symptomatisch für diese Veränderungen ist die aktuelle Diskussion über gezielte Desinformation, Social Bots und Wahlbeeinflussung durch Automatisierung und Big Data. Symptomatisch ist aber auch die Vermischung der Begriffe und die oft unscharfe Verwendung. Nicht jeder Bot und jeder Algorithmus ist per se schlecht - das muss man jedoch erst einmal wissen. Aufklärung und digitale Medienkompetenz sind der Schlüssel, damit der digitale Wahlkampf nicht zu automatisierter Meinungsmache werden kann.

Was für Bots gibt es eigentlich? Und was kann in politischen Meinungsbildungsprozessen automatisiert werden? Wie funktioniert Microtargeting und wozu kann dieses führen? Welche Chancen bringt die Digitalisierung der Meinungsbildung und Debattenkultur für unsere Demokratie? Und welche Risiken? Mit diesen Fragen setzt sich unsere neue Broschüre zum Thema politische Meinungsbildung im Netz auseinander.

Wir müssen auf die Eigenverantwortung, Digitalkompetenz und Kritikfähigkeit der Nutzerinnen und Nutzer setzen und diese altersunabhängig fördern. Falschmeldungen gibt es, seit es Medien gibt. Das Neue ist die rasante Verbreitung dieser im Internet durch Bots und das Filtern bereitgestellter Informationen durch Algorithmen. Über diese neuen „code-getriebenen“ Instrumente müssen die Bürgerinnen und Bürger zunächst informiert werden, um ihr verantwortungsvolles Medienverhalten weiterzuentwickeln. Diesem Anspruch will die Friedrich-Naumann-Stiftung für die Freiheit mit dieser Broschüre nachkommen.

Unsere Publikation

Politische Meinungsbildung im Netz

Die politische Öffentlichkeit wird immer digitaler und auch Wahlkämpfe finden zusätzlich zum klassischen Straßenwahlkampf online statt. Soziale Medien fungieren als eine neue Öffentlichkeit und sind über den Unterhaltungswert hinaus ein Ort, wo zum einen öffentlicher Diskurs stattfindet und zum anderen Menschen nach (politischen) Informationen suchen. Nicht nur ist ein Großteil von Bevölkerung und Presse aktiv in den Sozialen Medien, auch Politikschaffende und Parteien zeigen dort mehr und mehr Präsenz. Insbesondere Twitter erfreut sich großer Beliebtheit, weil dort Politikerinnen und Politiker kurze Kommentare zu aktuellen politischen Ereignissen abgeben können. Dort werden Meinungen von politischen Akteuren in beinahe Echtzeit verbreitet, ohne dass beispielsweise die Presse eingebunden werden muss. Die politische Seite kann sich so unverfälscht und schnell präsentieren, und die Wählerinnen und Wähler können sich wiederum schnell und unverfälscht einen Eindruck von den Politikerinnen und Politikern machen (Bader et al. 2015). Deshalb sind die Sozialen Medien in der politischen Meinungsbildung und auch in den Wahlkämpfen ein unerlässlicher Bestandteil geworden, der neben den klassischen Kanälen den politischen Marketingmix ergänzt.

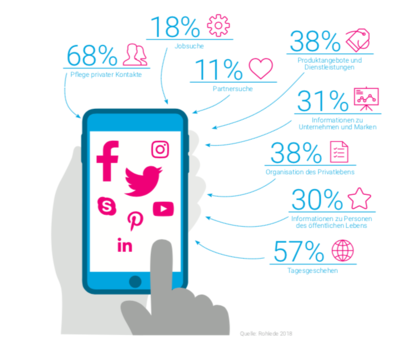

Wofür werden die sozialen Netzwerke genutzt?

Was wird automatisiert?

Automatisiert bedeutet, dass code-getriebene Instrumente (Skripte und Algorithmen) zur Verbreitung und Verstärkung von politischen Botschaften eingesetzt werden. Zusätzlich verfügen diese Instrumente über Big Data und können damit zielgruppenoptimiert ihren Content verbreiten.

In der Debatte um digitale Wahlkämpfe werden oftmals einzelne Akteure und Instrumente vermischt. Man unterscheidet in:

Das Budget der Parteien für den Online-Wahlkampf zur Bundestagswahl 2017 war so hoch wie noch nie zuvor. Dieser Wahlkampf wurde auch als der erste echte Online-Wahlkampf bezeichnet (Scherfig 2017).

Online-Budget der Parteien im Bundestagswahlkampf 2017 Angaben in Mio. Euro

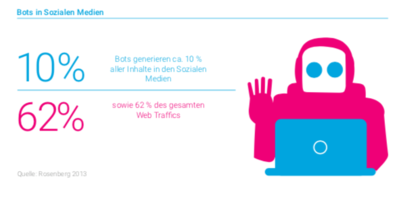

Bots

„Bots sind Computer Scripts, die menschliche Online-Aufgaben automatisieren“ (Rosenberg 2013). Ein Bot erledigt also kleinere, meist repetitive Aufgaben, die von Menschen als zu stupide wahrgenommen werden. Der Bot führt diese Aufgaben dann selbstständig basierend auf vorprogrammierten Regeln durch. Das kann das Verbreiten von Eilmeldungen sein, das Korrigieren von Rechtschreibfehlern oder das Ermitteln von Matches bei Online-Dating-Plattformen. Ursprünglich wurden Bots in den Sozialen Medien oft im Werbebereich genutzt – für Spamming, Click-Betrüge oder beispielsweise DDoS- und Virus-Attacken.

Social Bots werden vor allem auf Sozialen Netzwerken wie Twitter, Facebook oder Instagram gefunden. Dort können sie viele unterschiedliche Zielgruppen erreichen. Manche Bots sind eindeutig als automatisierte Accounts zu erkennen, andere geben sich bewusst verdeckt als menschliche Akteure aus.

Bots in Sozialen Medien

Social Bots – The good ...

Social Bots sind eine Unterkategorie von Bots. Sie sind automatisierte Accounts, die von einem Programm gesteuert werden. Ihr Ziel ist es, menschliches Verhalten nachzuahmen und dabei in den Kontakt mit anderen Nutzerinnen und Nutzern in Sozialen Netzwerken zu treten. Im Unterschied zum Chatbot – virtuellen persönlichen Assistenten wie Siri oder Alexa – sollen zur Meinungsmache eingesetzte Social Bots im Umgang mit Menschen nicht offenlegen, dass sie nicht menschlicher Natur sind. Solche Bots finden sich oft auf Facebook, Instagram oder Twitter und teilweise auch auf Online-Datingplattformen. Social Bots werden jedoch nicht zwangsläufig zu negativen oder manipulativen Zwecken eingesetzt.

Im politischen Bereich können beispielsweise Chatbots verwendet werden.

Die CSU nutzte im März 2017 den in Facebook integrierten Chatroboter Leo. Dieser versuchte, Wählerinnen und Wählern das Wahlprogramm näherzubringen, indem er auf bestimmte Fragestichwörter Antworten aus der Parteiprogrammatik gab. Leo war ausdrücklich als Chatbot gekennzeichnet (FAZ 2017). Auch die FDP nutzte einen Chatbot im Wahlkampf zur Bundestagswahl 2017 und unter dem Namen „@FDPShots“. User konnten bei Twitter an dieses Handle einen Begriff wie beispielsweise „Bildung“ oder „Rente“ schicken und der Bot antwortete in 140 Zeichen mit der entsprechenden Position aus dem FDP-Wahlprogramm (Liberale.de 2017).

... the bad

Im Rahmen von „Computational Propaganda“ spricht man deshalb eher von politischen Spambots. Diese haben das Ziel, politische Inhalte mit hohen Reichweiten zu verbreiten oder an politischen Diskussionen in Sozialen Netzwerken teilzunehmen. Bots sind sehr günstig in der Herstellung sowie der Wartung

und werden deshalb oft während Wahlkämpfen oder politischen Entscheiden von politischen Gruppen erschaffen, um ihre Botschaften und ihre Geisteshaltung zu kommunizieren.

Es kostet im Schnitt etwa 500 US-Dollar, eine Software zu unterhalten, die 10.000 Twitter-Accounts steuert. Dazu kommt noch der Preis für die User-Accounts. Je nach Ausgestaltungsgrad kosten 1.000 User-Profile nur 45 US-Dollar (Hegelich 2016).

Auch zur Verbreitung von „Fake News“ sind Social Bots prädestiniert, da diese datengetrieben agieren. So können passgenau relevante Zielgruppen ausgewählt und angesprochen werden. Das bedeutet auch, dass gezielt Diskurse manipuliert und faktisch nicht vorhandene Unterstützung für bestimmte Positionen generiert werden können.

... and the ugly bot

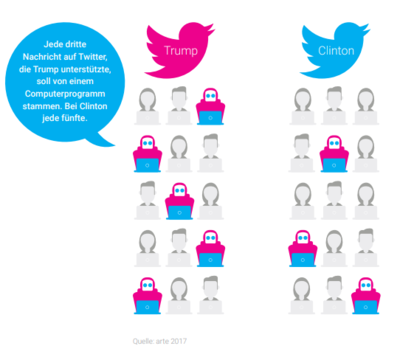

Im US-amerikanischen Präsidentschaftswahlkampf 2016, beim Brexit sowie bei der russischen Annexion der Krimhalbinsel wurden Social Bots auf Twitter genutzt. Es haben ca. 400.000 Social Bots Tweets zur politischen Diskussion über die US-Präsidentschaftswahl abgesetzt. Die automatisierten Accounts haben 20 Prozent aller Tweets zur Wahl verfasst (Bessi/Ferrara 2016). Eine Woche vor der Brexit-Entscheidung ließ sich eine erhöhte Anzahl an automatisch verfassten Tweets durch Social Bots messen, die das Pro-Brexit-Lager in den Sozialen Medien massiv unterstützt haben (Howard/Kollanyi 2016). Vor der Bundestagswahl 2017 ließ sich jedoch keine signifikante Bot-Aktivität verzeichnen (Neudert 2017).

Was sind typische Ziele beim Einsatz von politischen Spambots?

- Steigerung der Popularität von Personen oder Sichtbarkeit bestimmter Inhalte durch das Generieren von Likes und Followern

- Verstärkung von Themen (Eindruck erwecken, dass Menschen ihre Meinung äußern, wenn das Thema dominant ist

- Bots agieren als Multiplikatoren, die politische Botschaften verbreiten

- Aufspüren von Diskussionen und Beiträgen sowie Kommentaren durch spezifische Schlüsselwörter; im Anschluss werden diese durch automatisch generierte oder vorbereitete Inhalte überschwemmt, (man spricht von „flooding“), um weiteren Austausch oder Koordination zu verhindern.

Äußerst relevant für Bots sind Multiplikatoren wie einflussreiche Personen des öffentlichen Lebens (Politikerinnen und Politiker, Journalistinnen und Journalisten sowie Influencer). Sobald diese Gatekeeper bot-generierte Botschaften verbreiten, machen sie diese zum einen glaubwürdiger und vergrößern zum anderen die Reichweite der Bots. Das „Trenden“ von Hashtags bei Twitter (also Hashtags, die am meisten genutzt wurden) ist hierbei von zentraler Bedeutung.

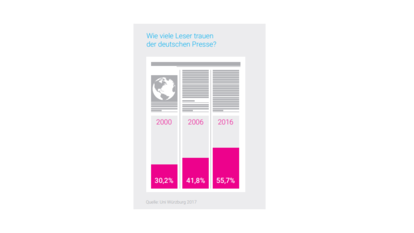

Unter den „Trending Topics“ befinden sich Themen, die besonders intensiv bei Twitter diskutiert werden. In diesen Prozess greifen Bots ein und verfassen millionenfach Tweets, die bestimmte Hashtags enthalten und sorgen so dafür, dass diese „trenden“. Viele Journalistinnen und Journalisten benutzen Twitter, um Stimmungen in der Bevölkerung abzufangen und zu erfahren, welche Themen besonders aktuell sind. So kann es passieren, dass ein Thema, das durch Bots zum „Trenden“ gebracht wurde, wiederum von der Presse ungefiltert übernommen wird. Nicht nur Journalistinnen und Journalisten, sondern auch Politikerinnen und Politikern fehlt manchmal noch die Sensibilität dafür, was ein politischer Spambot ist und wie dieser genau funktioniert. Es besteht also die Gefahr, auf diese und ihre Junk-News hereinzufallen.

Woran erkennt man Social Bots?

- sehr neue Profile mit wenigen Followern

- hohe Anonymität: wenige persönliche Angaben, kein Profilbild, Allgemeinplätze in Beschreibung

- twittert mit übermenschlicher Frequenz (mehr als 50 Tweets pro Tag)

- sehr schnelle Reaktionen (beispielsweise Retweets innerhalb von Sekunden)

- wenige eigene Veröffentlichungen, aber hohes Engagement

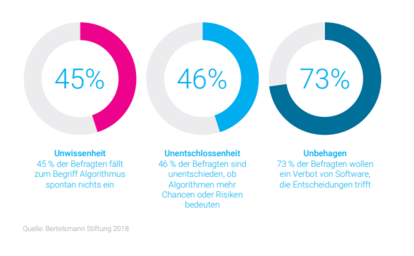

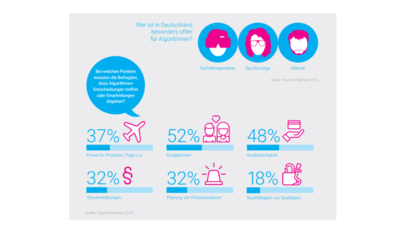

Was Deutschland über Algorithmen denkt und weiß:

Big Data & Microtargeting

Microtargeting ist ursprünglich eine Technik aus dem Werbebereich. Mit ihr können Online-Nutzer maßgeschneidert auf die Produkte angesprochen werden, die sie interessieren oder meinen haben zu müssen. Man nennt das personalisierte Werbung. Die Technik basiert auf den Daten aus dem Surfverhalten der User, die online kontinuierlich erhoben und als Cookies gespeichert werden. Diese Methode hat so gut im Werbebereich funktioniert, dass sie für politische Botschaften und den Wahlkampf übernommen wurde. Microtargeting ist dort die personalisierte und zielgerichtete Ansprache einzelner Wählerinnen und Wähler. Zudem können teilweise die Auswirkungen dieser Ansprache basierend auf zuvor erhobenen Daten vorhergesagt werden.

Effektive Wähleransprache

Unsere Gesellschaft wird immer heterogener. Früher wurde versucht, Wahlergebnisse anhand beispielsweise der Cleavage-Theorie (Lipset/Rokkan 1967) zu erklären. Es wurden also bestimmte Gruppen und Konfliktlinien einer Gesellschaft festgemacht, die bestimmte Wahlpräferenzen aufweisen. Arbeiterinnen und Arbeiter wählten beispielsweise eher sozialdemokratische Parteien. Heutzutage wird es aber immer schwieriger, einzelne große Gruppen innerhalb der Bevölkerung festzulegen und zu identifizieren wie beispielsweise „den Arbeiter“ oder „den Kapitalisten“. Deshalb können bestimmte Botschaften mit den alteingesessenen Wahlkampftechniken wie dem Wahlplakat in einer spezifischen Gegend immer weniger zielgruppenabgestimmt ausgespielt werden.

Im Internet sieht das anders aus. Dort kann man aufgrund vom Nutzungsverhalten genau bestimmen, welche Altersgruppen welches Thema in welcher Region relevant finden. Anhand von beispielsweise öffentlichen Facebook-Likes können sehr zuverlässige Aussagen über das Alter, Interessen, die politische Orientierung oder Gewohnheiten wie „pendeln“ getroffen werden. Diesen Usern wird dann ganz gezielt eine Botschaft oder politische Werbung auf Facebook oder Instagram zugespielt. So wird beispielsweise Nutzern, denen Umweltfragen wichtig sind, in der Anzeige erklärt, wie die Umweltpolitik bestimmter Kandidaten aussieht. Sind der Bürgerin oder dem Bürger sicherheitspolitische Fragen wichtig, werden diese auch vordergründig in der Wahlwerbung behandelt. Im Schnitt finden alle Wählenden in jedem Wahlprogramm Punkte, denen sie eher ablehnend oder zustimmend gegenüberstehen. Die genauen Präferenzen eines Wählers oder einer Wählerin können basierend auf dem Nutzungsverhalten abgeleitet werden. Parteien können dann passgenau Inhalte ihres Programms ausspielen, die eher auf Zustimmung stoßen werden.

Es gibt die unterschiedlichsten Erscheinungsformen des Microtargetings. Man kann beispielsweise personalisierte Wahlkampf-Werbung auf Facebook basierend auf den Interessen der Nutzerinnen und Nutzer ausspielen. Oder der Haustürwahlkampf wird durch Datenanalysen modifiziert. Bestimmten Hauszügen kann eine Wahrscheinlichkeit der Parteiaffinität zugeordnet werden (Hegelich 2017). Diese Ergänzung des Wahlkampfs kann positive Auswirkungen auf die Demokratie haben. Bürgerinnen und Bürger werden durch passgenaue individuelle Botschaften mehr abgeholt als durch einheitliche Wahlplakatsprüche. Zudem kann diese interessenorientierte politische Kommunikation zu mehr Interaktion vor Wahlen und politischen Entscheiden führen.

Dark Posts & Falschmeldungen

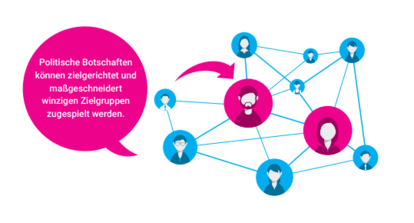

Enthalten Wahlplakate Falschmeldungen oder werden sie für den Rufmord einzelner politischer Personen genutzt, fällt dies schnell auf. Werden politische Botschaften jedoch maßgeschneidert winzigen Zielgruppen ausgespielt, kann dies nicht mehr kontrolliert werden.

Zudem führt diese Personalisierung der politischen Kommunikation zu einer weiteren Fragmentierung der politischen Öffentlichkeit. So kann es passieren, dass Personen, die sich nicht in der bestimmten Zielgruppe befinden, manche Botschaften nicht sehen. Das kann beispielsweise durch das Ausspielen von Dark Posts bei Facebook passieren. Die jeweiligen Botschaften werden dann nur der ausgewählten Zielgruppe, die über bestimmte Eigenschaften verfügt, gezeigt. Auf dem Profil der Partei und für andere Nutzerinnen und Nutzer sind sie jedoch nicht sichtbar. Werbeanzeigen dieser Art sehen zudem aus wie normale Posts und sind lediglich durch den Hinweis „gesponsert“ als solche erkennbar.

Insbesondere im US-amerikanischen Präsidentschaftswahlkampf zeigte sich das Missbrauchspotenzial des Microtargetings. So nutzte das Wahlkampfteam um Donald Trump diese Methode zur strategischen Demobilisierung bei der Wähleranhängerschaft Hillary Clintons. Nutzerinnen und Nutzer wurden gezielt Informationen über die Präsidenschaftskandidatin ausgespielt, die rufschädigend waren. Es wurde beispielsweise Usern, die von Facebook die ethnische Affinität „African American“ zugeordnet bekamen, ein Video-Snippet aus den 90er Jahren gezeigt, in dem Hillary Clinton den rassistisch konnotierten Begriff „super predators“ („Superraubtiere“) verwendet. Frauen wurden Posts ausgespielt, die auf Affären Bill Clintons hinwiesen. Diese Anzeigen wurden als Dark Posts ausgespielt und so konnte Hillary Clinton nur schwer dagegen vorgehen (Dachwitz 2017).

Was tun, wenn Meinung automatisiert wird?

Wie aktuelle Studien zeigen, ist in Deutschland derzeit die Bedrohung durch Social Bots sowie den Missbrauch durch Microtargeting als eher gering zu beurteilen (Hegelich 2017a, Neudert 2017a). Trotzdem fehlt ein effizienter Regulierungsrahmen, der sich generell mit neuen Technologien und der Verantwortung von Plattformbetreibern auseinandersetzt. Das im letzten Jahr verabschiedete Netzwerkdurchsetzungsgesetz (NetzDG) zeigt, dass eher versucht wird, Symptome zu bekämpfen, anstatt sich mit den dahinterliegenden Strukturen und deren Auswirkungen genauer zu befassen. Bisher agieren usergenerierte Inhalte und die Sozialen Medien als Contentplattformen in einem legalen Vakuum.

Social Bots

Vor der Bundestagswahl 2017 hatten alle Parteien versichert, keine Social Bots bei ihrem Wahlkampf zu verwenden. Eine gesetzliche Regelung zum Einsatz von politischen Spam Bots gibt es noch nicht. Im Raum steht die Forderung, alle Bots zu verbieten. Das bedeutet aber auch das Verbot von legitimen und sinnvollen Bots, wie beispielsweise Chatbots. Über eine Kennzeichnungspflicht für Bots wird auch gesprochen. Diesen Vorschlag haben die Justizminister der Länder im Herbst 2017 unterbreitet. Hier stellt sich die Frage, ab welchem Grad der Automatisierung diese Pflicht greifen soll. Zudem stehen die Server, von denen die Bots gesteuert werden, oft in anderen Ländern. Die Durchsetzung von deutschen Rechtsordnungen, wie beispielsweise Verbote von Bots, ist im Ausland, wo anderes Recht gilt, ohne Kooperationsvereinbarung oder supra-nationale Regelungen (z.B. EU-weit) sehr schwierig.

Microtargeting

Im Bundestagswahlkampf 2017 haben alle Parteien in unterschiedlichen Ausprägungen Microtargeting verwendet. Eine Regulierung hierzu gibt es noch nicht.

Diskutiert wird ein Transparenzregister für politische Parteien, in dem zielgruppenoptimierte Werbung gespeichert wird. Soziale Netzwerke könnten auch in ihrer Funktion als Werbungsplattformen stärker kontrolliert werden. Zwar betrachten Facebook und Twitter als private Wirtschaftsunternehmen ihre Algorithmen als geistiges Eigentum. Trotzdem könnten sie Auditing-Verfahren unterzogen werden. Diese gelten für Algorithmen, die das öffentliche Interesse berühren, wie beispielsweise Algorithmen von Spielautomaten oder Algorithmen des Finanzhandels.

Seit Mai 2018 ist die Datenschutzgrundverordnung in Kraft getreten. Diese erlaubt Microtargeting nur unter strengen Voraussetzungen. Es werden in der Regel auch Soziale Netzwerke außerhalb Deutschlands erfasst. Die Verordnung gilt, wenn das Nutzungsverhalten von Nutzerinnen und Nutzern innerhalb der EU beobachtet wird. Sie ist auch anwendbar, wenn dabei die Daten außerhalb der EU verarbeitet werden (Art. 3 DSGVO).

Medienkompetenz als Schlüssel

Die wichtigste Maßnahme, um dem Einfluss automatisierter Meinungsmache entgegenzuwirken, ist die Vermittlung von Medienkompetenz durch alle Altersklassen. Der Schwerpunkt der klassischen Medienkompetenz muss um die Komponente der Informationskompetenz ausgeweitet werden.

Dazu gehört das Wissen über die einzelnen Aspekte und Werkzeuge automatisierter Meinungsmache sowie ihre Wirkung. Wenn Medienkonsumenten zudem die kognitiven und affektiven Mechanismen ihrer eigenen Medienrezeption verstehen, sind sie besser auf Medieneinflüsse vorbereitet. Zudem ist auch immer die Auseinandersetzung mit dem eigenen Nutzungsverhalten sowie Medienkonsum von großer Bedeutung (Müller/Denner 2017).

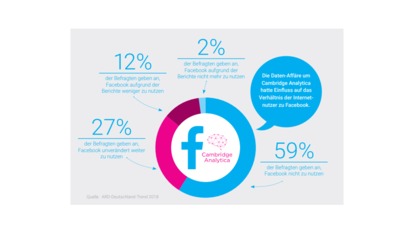

Nutzerinnen und Nutzer müssen wissen, dass sie es nicht immer mit Menschen im Netz zu tun haben, sondern eben auch mit Chatrobotern. Diese Bots können zu unterschiedlichen Zwecken eingesetzt werden; oftmals erweisen sie uns gute Dienste. Manchmal werden diese Bots aber auch zur Meinungsmache eingesetzt. Und genau diese politischen Spambots müssen von den Usern als solche erkannt und kritisch hinterfragt werden. Nutzerinnen und Nutzer müssen durch mehr Aufklärung lernen, kritischer gegenüber Inhalten und Nachrichten gegenüber den Sozialen Medien zu sein. Nicht die Plattformen müssen abwägen, welche Nachrichten „Fake News“ sein könnten, sondern die User selbst. Facebook sollte nicht als Primärquelle für Informationen genutzt werden.

Auch unser Umgang mit Algorithmen und Big Data muss reflektierter sein. Der Einsatz von diesen erleichtert unser Leben in vielen Bereichen. Trotzdem beeinflussen Algorithmen durch gezieltes Filtern unsere Wahrnehmung. Alle Internetnutzerinnen und -nutzer müssen sich darüber im Klaren sein, dass sie ein anderes Google-Suchergebnis angezeigt bekommen als ihre Nachbarn. Teil der medialen Aufklärung muss sein, wie Algorithmen funktionieren, wo diese überall eingesetzt werden und vor allem, dass sie datenbasiert sind.

ARD-Deutschlandtrend, 61 Prozent der Internetnutzer haben Sorge vor Datenmissbrauch. Vertrauen in Facebook ist gering, 2018, https://presse.wdr.de/plounge/tv/das_erste/2018/04/20180405_ard_deutsch…. Arte, Sind unsere Wahlen gekauft, 2017, https://info.arte.tv/de/social-bot-bundestagswahl-manipulation. C. Bader, K. Fuchs, C. Güthlein, O. Kamm, T. Schunk & M. Maurer, Die Wahl in 140 Zeichen – Twitter als Kommunikationsplattform für Politik, Medien und Bürger im Bundestagswahlkampf 2013, in: Politische Psychologie, Heft 1, 2015, S. 5-22. Deutscher Bundestag, Hegelich erwartet keine große Gefahr durch Social Bots im Wahlkampf, 2017, https://www.bundestag.de/dokumente/textarchiv/2017/kw29-w-forum/514278. I. Dachwitz, Wahlkampf in der Grauzone: Die Parteien, das Microtargeting und die Transparenz, 2017, https://netzpolitik.org/2017/wahlkampf-in-der-grauzone-die-parteien-das…. S. Fischer, T. Petersen, Was Deutschland über Algorithmen weiß und denkt, Gütersloh 2018, https://www. bertelsmann-stiftung.de/fileadmin/files/BSt/Publikationen/GrauePublikationen/Was_die_Deutschen_ ueber_Algorithmen_denken.pdf. S. Hegelich, Social bots: Invasion der Meinungsrobotor, 2016, http://www.kas.de/wf/de/33.46486/. S. Hegelich, #FDPleaks: Hype und Hybris im Datenwahlkampf, Political Data Science Blog, 2017, http://politicaldatascience.blogspot.de/2017/08/fd pleaks-hype-und-hybris-im.html (Hegelich 2017a). P. N. Howard, S. C. Wooley, Political Communication, Computational Propaganda, and Autonomous Agents, in: International Journal of Communication 10, 2016, S. 4882–4890. P. N. Howard, B. Kollanyi, Bots, #StrongerIn, and #Brexit: Computational propaganda during the UK-EU referendum 2017, http://arxiv.org/abs/1606.06356. Liberale.de, Die FDP in 140 Zeichen, 2017. S. M. Lipset, S. Rokkan, Cleavage Structures, Party Systems and Voter Alignments. An Introduction, in: S. M. Lipset, S. Rokkan (Hgg.), Party Systems and Voter Alignments. Cross-National Perspectives, New York 1967, S. 1–64. P. Müller, N. Denner, Was tun gegen Fake News, Eine Analyse anhand der Entstehungsbedingungen und Wirkweisen gezielter Falschmeldungen im Internet, Potsdam 2017. L.-M. Neudert, Computational Propaganda in Germany: A Cautionary Tale, in: S. Woolley and P. N. Howard, Eds. Working Paper, Oxford 2017, S. 31 ff. L.-M. Neudert, P. Howard & B. Kollanyi, Junk news and bots during the German federal presidency election: What were German voters sharing over Twitter?, 2017, http://comprop.oii.ox.ac.uk/wpcontent/ uploads/sites/89/2017/03/What-Were-German-Voters-Sharing-OverTwitter-v6-1.pdf (Neudert 2017a). K. Otto, A. Köhler, Vertrauen in die Medien so hoch wie seit 15 Jahren nicht mehr, Würzburg 2017, https://www.wiwi.uni-wuerzburg.de/lehrstuhl/professur-fuer-wirtschaftsj…. 18 B. Rohlede, Social-Media-Trends, Bitkom, 2018, https://www.bitkom.org/Presse/Anhaenge-anPIs/2018/180227-Bitkom-PK-Char…. Y. Rosenberg, 62 percent of all web traffic comes from bots, 16 December 2013, http://theweek.com/ articles/454320/62-percent-all-webtraffic-comes-from-bots. L. Scherfig, Das sind die Trends im digitalen Wahlkampf 2017, in: Der Westen, 2017, https://www.derwesten.de/politik/das-sind-die-trends-im-digitalen-wahlk…. Statista, Statistiken zur Social-Media Nutzung, 2018, https://de.statista.com/themen/1842/sozialenetzwerke/. T. Steppert, Die CSU hat einen neuen Chatroboter, 2017, http://www.faz.net/aktuell/politik/inland/ wahlkampf-die-csu-hat-einen-neuen-chat-roboter-14996490-p2.html (FAZ 2017). YouGov, Politisches Informationsverhalten der Deutschen: Messenger und Social Media hoch im Kurs, 2017, https://yougov.de/news/2017/04/03/politisches-informationsverhalten-der….